AI在科研领域有广泛的应用场景和需求,有众多很不错的开源项目针对AI科研助手,一些不错的项目:

STORM:https://github.com/stanford-oval/storm

AI-Scientis:https://github.com/SakanaAI/AI-Scientist

Google Gemini Deep Research:https://gemini.google/advanced/

Automated-AI-Web-Researcher-Ollama:https://github.com/TheBlewish/Automated-AI-Web-Researcher-Ollama

Research Rabbit:https://github.com/langchain-ai/research-rabbit

Open Deep Research:https://github.com/btahir/open-deep-research

AgentLaboratory:https://github.com/SamuelSchmidgall/AgentLaboratory

这些项目核心功能都是:给定主题后,由AI助手自动搜索互联网、arXiv等数据源,汇总相关的研究成果,然后汇总、摘要、生成报告。

整体而言,此类项目基本上涵盖了科研标准化的过程。

而现实的科研工作,对于某个主题并非一蹴而就的,而是需要对相关的研究主题不停打磨完善,持续完善。

ChatGPT-o1的思维链模式、DeepSeek的强化学习和多轮对话都表明,通过分拆任务、多步思考、多轮探索可以提升AI产出的质量。

那么能不能对AI科研也采用类似的思路呢?

Ollama Deep Researcher 是一款完全本地化的网络研究助手,可使用任何 基于Ollama的LLM(例如最近火爆的DeepSeek-R1)。

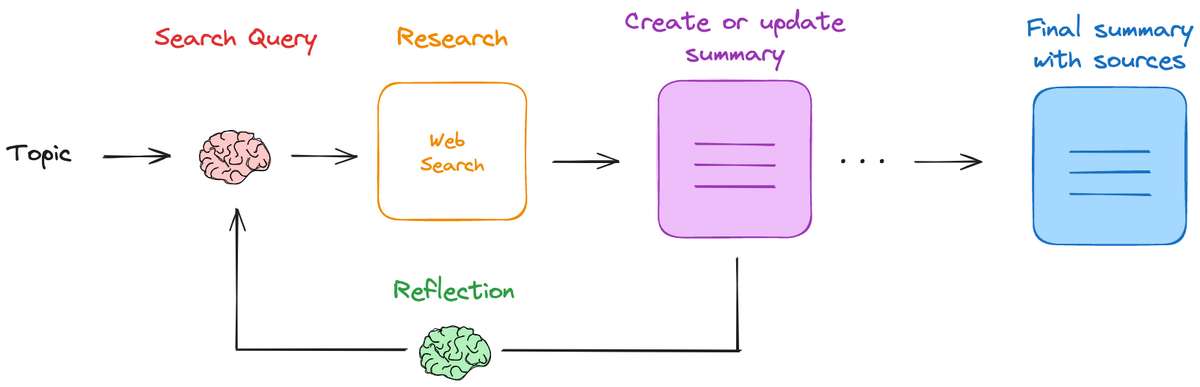

Ollama Deep Researcher 会根据输入的主题,生成一个网络搜索查询,收集网络搜索结果,总结网络搜索结果,反思总结以检查知识差距,生成一个新的搜索查询以弥补差距,搜索,并在用户定义的循环次数内改进总结。最终提供markdown 格式的摘要以及所有使用的来源。

最值得称道的是 M1 16G 的 Mac 就可以运行Ollama Deep Researcher 。

Ollama Deep Researcher 的灵感来自 IterDRAG。这种方法将查询分解为多个子查询,检索每个子查询的文档,回答子查询,然后在回答的基础上检索第二个子查询的文档。

Ollama Deep Researcher的核心流程:

- 给定用户提供的主题,使用本地 LLM(通过 Ollama)生成网络搜索查询

- 使用搜索引擎查找相关来源

- 使用 LLM 总结与用户提供的研究课题相关的网络搜索结果

- 然后,使用 LLM 对摘要进行反思,找出知识差距

- 生成新的搜索查询,以解决知识差距问题

- 重复这一过程,并根据网络搜索的新信息反复更新摘要

- 重复研究兔子洞

- 运行指定的迭代次数(迭代次数可配置)